ITCAAD

Link al corsoCiclo 2

Il mondo dei pixel

Materialià e immaterialità

Hardware e schermi, la digitalizzazione delle immagini

Il mondo raster

L7: Evoluzione del computer. Dal pallottoliere allo schermo grafico e oltre

L8: Dentro i Bits. Il mondo raster

L9: Leggere, Scrivere, Presentare: La Collana La Rivoluzione Informatica in Architettura

L10: Architettura e presenze delle superficie

L11: Tema d'anno TTLine (ToLine)

TTLine: una questione sull'infrastruttura

La TT-Line rappresenta una riflessione profonda su come le infrastrutture urbane possano non solo sostenere la crescita della città, ma rigenerarla in modo sostenibile.

L'obiettivo è sviluppare un concept di infrastruttura che risponda ai bisogni attuali, trasformando aree dismesse e degradate in spazi vitali e funzionali, dove pubblico e cittadinanza convergono in un'unica infrastruttura.

Cos’è la TT-Line?

La TT-Line si basa sulla Linea 2 del tram di Roma, una linea anacronistica creata nel 1990 per i mondiali di calcio, senza una visione realmente lungimirante per il tessuto urbano.

Il percorso, che si snoda lungo la storica via Flaminia, è rimasto invariato, ma non all'altezza dei bisogni attuali della città. Tuttavia, proprio per questo, potrebbe diventare il modello di un’infrastruttura che parte dalla “negatività” per rifondarsi e trovare nuove soluzioni per la città contemporanea.

Il Ruolo delle Infrastrutture nella Crescita Urbana

Nessuna città può svilupparsi senza infrastrutture. I Romani lo sapevano bene, costruendo strade e acquedotti che collegavano e alimentavano Roma stessa. Il percorso della TT-Line segue una di queste antiche vie consolari, unendo idealmente passato e futuro. Le infrastrutture sono da sempre alla base dell’espansione urbana, come è stato per la ferrovia durante il secondo boom di crescita delle città.

Tuttavia, oggi ci troviamo di fronte a nuove sfide. Il consumo di suolo è diventato insostenibile e siamo vicini a una crisi irreversibile. Se non possiamo più espanderci su nuovi terreni, come possiamo permettere uno sviluppo che rispetti i limiti ambientali?

Strategie per lo Sviluppo Sostenibile

L’alternativa è rivitalizzare il suolo già urbanizzato. Ecco due approcci chiave:

- Riqualificazione delle aree degradate: trasformare zone in disuso in spazi pubblici utili e moderni.

- Infrastrutture all’interno della città esistente: portare infrastrutture moderne nelle aree abbandonate, evitando l’espansione urbana.

Alcuni esempi di successo a livello internazionale includono:

- High Line a New York: un'ex linea ferroviaria elevata è stata trasformata in uno spazio verde urbano.

- Cheonggyecheon Stream a Seoul: un’autostrada dismessa è stata convertita in una passeggiata urbana lungo il fiume.

- Giardini sopraelevati di Sant Antoni a Barcellona: un giardino creato in un’area precedentemente inutilizzata.

Imprinting delle Infrastrutture: Le Vie Cave Etrusche

Un esempio storico di infrastrutture innovative e multifunzionali sono le vie cave etrusche. Scavate a mano nella roccia tufacea, queste gallerie non erano solo strade: servivano come percorsi processionali, legati alla religione e alla spiritualità e veri e proprie cave, dalle quali ricavavano il tufo per la realizzazione di edifici di culto. Erano infrastrutture radicate nel rispetto e nella ciclicità della natura, rappresentando un modello di output che diventa input, in un eterno ritorno.

TT-Line: I 7 Principi di una Nuova Infrastruttura Urbana

I principi chiave della TT-Line riflettono una visione moderna e sostenibile dell’infrastruttura, ispirata da esempi passati e innovazioni contemporanee:

- Multifunzionalità: come le vie cave, ogni infrastruttura deve avere una doppia funzione, superando la mera utilità industriale.

- Green Systems: creare corridoi ecologici, come la High Line, che favoriscano la continuità della biodiversità e l’integrazione del verde urbano.

- Information Technology Foam: integrare tecnologie reattive nell’ambiente urbano per rispondere dinamicamente ai bisogni.

- Living Accessibility: valorizzare lo spostamento lento, offrendo percorsi pedonali di qualità per una migliore esperienza cittadina.

- Cittadinanza: l’infrastruttura deve essere un veicolo di bellezza civica e consapevolezza pubblica, rafforzando l'identità comunitaria.

- Upon the Sky: pensare in verticale.

- Down the Land: rispettare e valorizzare il terreno urbano già costruito, evitandone il consumo e dandogli importanza.

La TT-Line quindi si propone come un prototipo di infrastruttura che non solo supporta la crescita urbana, ma anche la rigenerazione della città. Una progettazione intelligente che integra la multifunzionalità, la sostenibilità ambientale e l’inclusività sociale può essere la chiave per uno sviluppo urbano etico e resiliente.

Il Mondo Raster e la Superficie nell'Architettura Digitale

Nel mondo moderno, la comunicazione visiva è dominata dal raster, un sistema che comunica tramite punti, conoscendo solo punti e schermo. Questo sistema ha dato origine a una rivoluzione che ha attraversato molti ambiti, incluso quello dell’architettura, con la sua capacità di riprodurre colori e forme tramite la tecnologia digitale.

Il colore, sotto l’invenzione del mondo raster, è definito dal sistema RGB (Rosso, Verde, Blu), che oggi costituisce la base di tutte le visualizzazioni digitali, sia nei dispositivi che nelle architetture virtuali.

Ma quale impatto ha avuto il mondo raster sull'architettura? Per noi, nati in un'epoca in cui il digitale è parte integrante della vita quotidiana, questo impatto è percepito in modo naturale. La presenza di computer e televisori a colori ha formato un'immagine mentale del mondo che ora pensiamo e vediamo in termini di pixel, risoluzioni e schermi.

Architettura e la Visione del Mondo Digitale

Nella ricerca architettonica, un concetto che ha preso piede è quello di

Weltanschauung,

ovvero la visione del mondo, che si è evoluta attraverso le arti, la filosofia e la cultura.

Nel contesto digitale, questa visione è influenzata dalle superfici, che giocano un ruolo cruciale nella nostra percezione. Pensiamo ad esempio alla superficie di uno schermo: essa diventa non solo un "contenitore" di immagini, ma anche una "finestra" che ci permette di vedere e interpretare il mondo.

Superficialità o Profondità?

Il concetto di superficie in architettura ha una nuova valenza. Se nel passato movimenti come il Bauhaus concepivano le superfici come piane e trasparenti, senza decorazioni, oggi la superficie è tornata in auge con un ruolo decorativo e profondo. La superficie non è più solo estetica, ma si lega alla percezione della profondità e della complessità, proprio come la nostra pelle, che pur essendo superficiale, rivela la nostra essenza.

In architettura, la superficie ha anche un'importanza legata alla prospettiva, che è stata studiata empiricamente da figure come

Albrecht Dürer,

il quale utilizzava un telaio per analizzare la prospettiva.

Lo stesso concetto lo ritroviamo nell'opera di

Caravaggio,

che ha rivoluzionato l’estetica pittorica, usando strumenti come lo specchio per creare un autoritratto della morte in La Medusa, rappresentando il momento esatto in cui la vita lascia il corpo.

L'Influenza della Tecnologia sull'Architettura Contemporanea

Nel 1984,

Steve Jobs e il

MIT

introdussero una serie di innovazioni che avrebbero cambiato il volto dell'architettura e del design.

Negli stessi anni, l'industria tecnologica stava preparando il terreno per le interfacce che oggi vediamo quotidianamente: dalle prime previsioni di

Negroponte

sulle interfacce touchscreen alla nascita del

Macintosh, l'architettura ha cominciato a integrare nuove modalità di interazione.

In architettura, questo ha significato la nascita di superfici interattive, dove la pelle degli edifici diventa un elemento che non solo risponde agli stimoli esterni, ma partecipa attivamente alla creazione di nuove esperienze sensoriali.

La superficie diventa così parte integrante del processo produttivo e del design.

Superfici come Parte del Processo Produttivo

Un esempio emblematico di questo approccio è la Biblioteca dell’Università di Utrecht progettata da Wiel Arets, che ha scelto di decorare le superfici con motivi vegetali serigrafati, incisi o dipinti. All’interno di queste superfici, vengono create diverse profondità visive che rendono ogni superficie un elemento unico, con una forte connessione tra estetica e funzionalità.

Anche in progetti più recenti, come la Torre Glòries a Barcellona, vediamo come la superficie, se osservata da vicino, riveli un "mondo raster" che si sviluppa in un panorama visivo fatto di pixel, colori e texture.

Il Mercado de Santa Catalina di Enric Miralles e Benedetta Tagliabue esplora la stessa idea, con una copertura che funge da tappeto digitalizzato, dove la palette di colori nasce direttamente dalle merci del mercato, mostrando come la superficie possa raccontare la storia di un luogo.

Iconografia e Elettronica in Architettura

Nel mondo contemporaneo, l'architettura non è solo un gioco di forme e materiali, ma è anche profondamente legata alla cultura elettronica e alla iconografia.

Robert Venturi, con il suo libro

https://mitpress.mit.edu/9780262720298/iconography-and-electronics-upon-a-generic-architecture/Iconography and Electronics upon a Generic Architecture, ha contribuito a definire come l'architettura oggi si confronti con l'immagine, l'elettronica e la superficie.

Herzog e De Meuron, con i loro edifici, riescono a creare superfici che non sono solo estetiche, ma che raccontano storie e emozioni, come nel caso dello

Allianz Arena, la cui pelle di materiale plastico ignifugo è "animata" da luci e animazioni.

La Pelle Mobile dell'Architettura

Un esempio sorprendente della "pelle mobile" è il progetto The Shed di Diller + Scofidio. Qui la superficie degli edifici non è statica, ma dinamica e in continua evoluzione, adattandosi alle esigenze di spazio e funzione in tempo reale. Questa innovazione rappresenta una delle vette più avanzate della progettazione architettonica moderna, dove la superficie non solo copre, ma si adatta, si trasforma e si risponde ai cambiamenti nel tempo.

Il mondo raster ha avuto un impatto profondo sull'architettura moderna, non solo come tecnica, ma come filosofia e linguaggio. La superficie, che un tempo era intesa come un semplice elemento estetico, è oggi un portatore di significati profondi, che si riflettono nella nostra percezione dell’ambiente e nella creazione di spazi che non sono più solo fisici, ma anche digitali e interattivi. La tecnologia ha trasformato la superficie in una tela viva, capace di rispondere ai nostri stimoli e di raccontare nuove storie visive, integrando la dimensione estetica con quella funzionale in un dialogo continuo tra il passato e il futuro dell’architettura.

29.10.2024

L9: Leggere, Scrivere, Presentare:

La Collana La Rivoluzione Informatica in Architettura

vai alla lezione

Mercoledì 13 Novembre – ESAME INTERMEDIO

L'esame intermedio consisterà in una presentazione del proprio sito web, della durata di 10-15 minuti.

La presentazione dovrà includere una serie di attività e approfondimenti che metteranno alla prova la nostra comprensione della rivoluzione informatica applicata all’architettura.

A. Recensione: "La Rivoluzione Informatica in Architettura"

Il primo compito è scrivere una recensione critica su uno o più volumi della lista sottostante, che esplorano come l'informatica ha trasformato l’architettura e i processi progettuali. Questa è un’opportunità per approfondire concetti avanzati, fare confronti e sottolineare il valore dei contributi digitali. La lista dei volumi, in ordine cronologico, include:

link ai volumi

Luigi Prestinenza Puglisi, HYPERARCHITETTURA - spazi nell'età dell'elettronica

Gerard Schmitt, INFORMATION ARCHITECTURE - basi e futuro del CAAD

Luca Galofaro, EISENMAN DIGITALE - uno studio dell'era elettronica

Mirko Galli, Claudia Mühlhoff, TERRAGNI VIRTUALE - il CAAD nella ricerca storico-critica

Maia Engeli, STORIE DIGITALI - poetiche della comunicazione

Christian Pongratz, Maria Rita Perbellini, NATI CON IL COMPUTER - giovani architetti americani

Marco Galofaro, RISCATTO VIRTUALE - Una nuova fenice a Venezia

Maria Luisa Palumbo, NUOVI VENTRI - Corpi elettronici e disordini architettonici

Alicia Imperiale, NUOVE BIDIMENSIONALITÁ - tensioni superficiali nell'architettura digitale

Paolo Martegani, Riccardo Montenegro, DESIGN DIGITALE - Nuove frontiere degli oggetti

Gianni Ranaulo, LIGHT ARCHITECTURE - New Edge City

Derrick De Kerckhove, L'ARCHITETTURA DELL'INTELLIGENZA

Bruce Lindsey, GEHRY DIGITALE - Resistenza materiale costruzione digitale

Valerio Travi, TECNOLOGIE AVANZATE - Costruire nell'era elettronica

Kari Jormakka, OANDESI VOLANTI - il movimento in architettura

Furio Barzon, LA CARTA DI ZURIGO - Eisenman De Kerckhove Saggio

Markus Bandur, ESTETICA DEL SERIALISMO INTEGRALE - La ricerca contemporanea dalla musica all'architettura

Francesco De Luca, Marco Nardini, DIETRO LE QUINTE - tecniche d'avanguardia nella progettazione contemporanea

Paola Gregory, TERRITORI DELLA COMPLESSITÁ - New Scapes

Makoto Sei Watanabe, INDUCTION DESIGN - Un metodo per una progettazione evolutiva

Patrik Schumacher, HADID DIGITALE - Paesaggi in movimento

IAN+, ODISSEA DIGITALE - Un viaggio nel Mediterraneo

Michele Emmer, MATHLAND - Da mondo piatto alle ipersuperfici

Antonello Marotta, DILLER + SCOFIDIO - Il teatro della dissolvenza

Alberto Iacovoni, GAME ZONE - Playground tra scenari virtuali e realtà

Alexandro Ladaga, Silvia Manteiga, STRATI MOBILI - Video contestuale nell'Arte e nell'Architettura

Dimitris Papalexopoulos, Eleni Kalafati, TAKIS ZENETOS - Visioni digitali, architetture costruite

Antonello Marotta, Paola Ruotolo, ARIE ITALIANE - Motivi dell'architettura italiana recente

Alexander Levi, Amanda Schachter, STANZE RIBELLI - Immaginando lo spazio hacker

Nigel Whiteley, PENEZIC ROGINA - digitalizzazione della realtà

Kas Oosterhuis, IPER CORPI - Verso una architettura e-motiva

Patrizia Mello, ITO DIGITALE - Nuovi media, nuovo reale

Stefano Converso, SHoP WORKS - Collaborazioni costruttive in digitale

Christian R. Pongratz, Maria Rita Perbellini, CYBER STONE - Innovazioni digitali sulla pietra

Michael Leyton, LA FORMA COME MEMORIA - Una teoria geometrica dell'architettura

Andrea Sollazzo, VAN BERKEL DIGITALE - Diagrammi processi modelli di UNstudio

Cesare Griffa, SMART CREATURES - Progettazione parametrica per architetture sostenibili

Maria Elisabetta Bonafede, PLASMA WORKS - Dalle geometriche topologiche al landscape urbanism

Antonino Di Raimo, FRANÇOIS ROCHE - Eresia macchiniche e architetture viventi di New-Territories.com

B. Creazione del Concept di TT LINE

Questo concept personale rappresenterà il primo passo verso la creazione di nuovi prodotti e servirà come base per successive elaborazioni di gruppo. Il concept dovrebbe rispondere a uno dei seguenti spunti:

- Una crisi attuale (es. inquinamento, sovraffollamento) o locale

- Un interesse personale o un bisogno specifico

- Un aspetto rilevante di TT LINE, magari già trattato nel Laboratorio

- Una tecnologia innovativa o un’idea che coinvolga il concetto di cittadinanza, integrazione, o appropriazione urbana.

C. Autoritratto della Crisi in un Programma Raster

Creare un autoritratto che rappresenti una “crisi” utilizzando un programma raster (es. Photoshop). Questo progetto rappresenta un momento di introspezione, riflettendo visivamente una difficoltà o sfida personale o professionale legata all'architettura o al mondo contemporaneo. L'uso del raster (immagine a pixel) richiama la digitalizzazione e la frammentazione, offrendo una metafora visuale dell’attuale condizione sociale e personale.

È vivamente consigliato avvalersi dell'Intelligenza artificiale

D. Approfondimenti Scritti

Presentare almeno tre approfondimenti scritti, partendo dal tema “Nuove Sostanze”. Questo è il momento per mostrare l'impegno e interesse per l’argomento, evidenziando le connessioni tra le sostanze digitali, i materiali architettonici e il cambiamento paradigmatico nell’architettura digitale.

E. Studio del Libro “Introduzione alla Rivoluzione Informatica in Architettura”

Leggere fino a pagina 104 del testo "Introduzione alla rivoluzione informatica in Architettura" (o la nuova edizione "Thoughts on a Paradigm Shift").

F. Strategia di Presentazione

Siamo entrati nel mondo raster, una realtà fatta di puntini e di griglie, dove tutto ciò che vediamo è scomposto in minuscole unità grafiche. Questo mondo, simboleggiato da strumenti come

Adobe Photoshop,

è la base delle immagini digitali e della grafica che oggi vediamo ovunque.

La lezione ci porta a esplorare la rivoluzione dello schermo grafico, che da oltre 30 anni è parte integrante della nostra vita. Ma lo schermo è molto di più: è un’entità doppia, fatta di punti grafici e, al tempo stesso, capace di "leggere" informazioni strutturate.

Un nuovo personaggio: Leonardo 1

Per comprendere meglio i vari ambienti dell’informatica, immaginiamo di eliminare gli strumenti moderni come il computer e l’elettricità, riportandoci idealmente ai tempi di

Leonardo da Vinci.

Come farebbe Leonardo a trasmettere un disegno o un testo a distanza senza l’ausilio di strumenti elettronici?

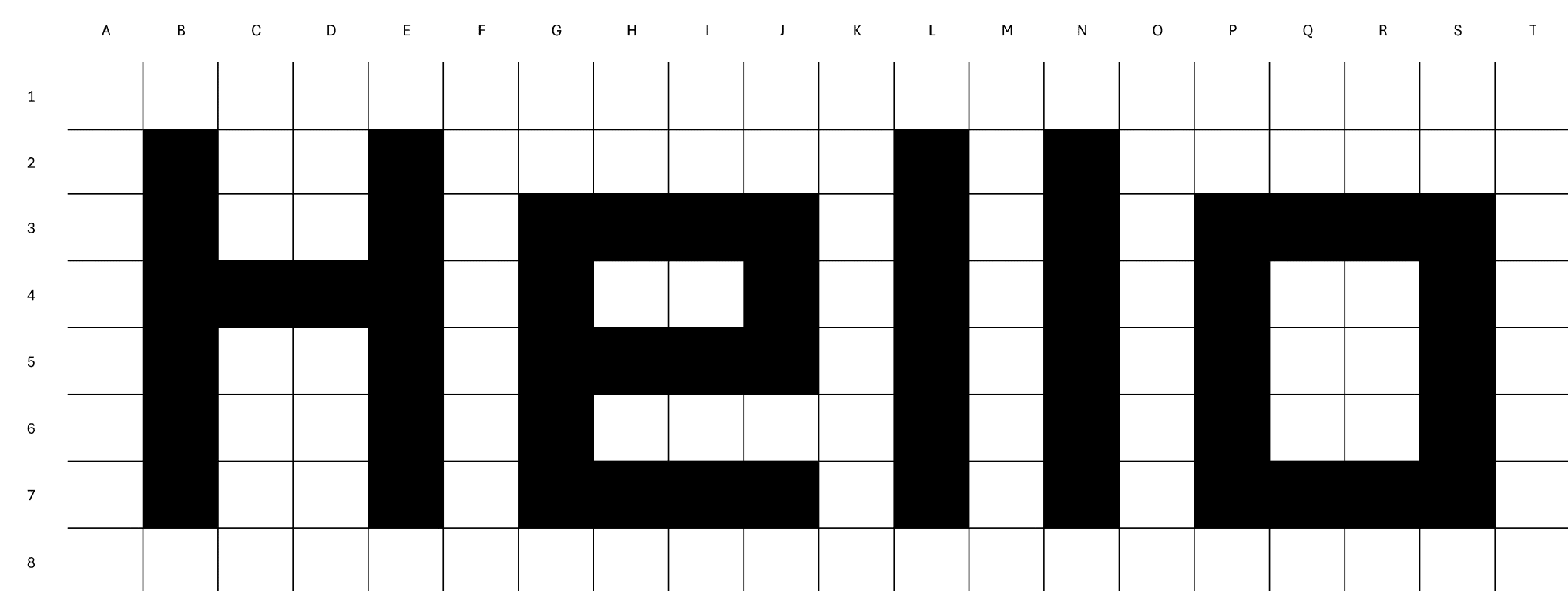

Ecco che nasce l’idea di una griglia alfanumerica: una rappresentazione schematica e logica dello schermo, dove ogni punto (o pixel) è rappresentato da una combinazione di coordinate.

Ecco un esempio:

Ho appena ricevuto questo codice, come lo decodifico?

B2-B3-B4-B5-B6-B7-C4-D4-E2-E3-E4-E5-E6-E7-G3-G4-G5-G6-G7-H3-H5-H7-I3-I5-I7-J3-J4-J5-J7-L2-L3-L4-L5-L6-L7-N2-N3-N4-N5-N6-N7-P3-P4-P5-P6-P7-Q3-Q7-R3-R7-S3-S4-S5-S6-S7

Giorgia Mingotto, Decodifica di un messaggio

Questo schema permette di costruire e trasmettere immagini in bianco e nero semplicemente indicando la posizione dei puntini. La griglia diventa quindi uno schermo raster virtuale, dove ogni cella è accesa (1) o spenta (0), formando così l’immagine. Non è il computer a interpretare il significato dell’immagine, ma chi legge il codice: ogni punto bianco o nero è un’informazione base, che noi chiamiamo “bottom”, ovvero informazione raster.

La rivoluzione dello schermo e della risoluzione

Lo schermo lavora a una risoluzione standard di 72 dpi (punti per inch), adatta per la visualizzazione digitale. Aumentando la densità dei punti, la risoluzione diventa più dettagliata: a 150 dpi si ottiene una qualità accettabile, mentre a 300 dpi si raggiunge una risoluzione minima per la grafica stampata. Anche la tecnologia di ingresso (fotocamere e scanner) funziona in base a questo principio, permettendo di impostare la risoluzione desiderata.

Colore e profondità del colore: dal bianco e nero all’arcobaleno digitale

Il mondo digitale ha poi aggiunto il colore grazie al codice RGB (Rosso, Verde, Blu), dove ogni colore è rappresentato da una combinazione di intensità. Partendo da quattro colori fondamentali (incluso il nero per l’assenza di colore), raddoppiando i bit di profondità arriviamo a una gamma di colori sempre più vasta: 8 colori, poi 16, fino a 32 bit e oltre.

Grazie a queste tabelle, anche Leonardo, in teoria, avrebbe potuto trasmettere la Gioconda con tutti i suoi colori, uno schema per ogni pixel del dipinto.

La realtà e la risoluzione: più dettagli dell’occhio umano

La nostra mente è abituata a percepire il mondo in modo fluido, senza pixel. Paradossalmente, un’immagine raster ad altissima risoluzione offre più informazioni di quelle che possiamo cogliere a occhio nudo da una distanza naturale.

Perchè un'immagine ha più informazioni del reale?

La realtà ha infinite informazioni, quindi allo stesso tempo nessuna informazione.

Ad esempio, visitando virtualmente una galleria con

Google Arts & Culture,

possiamo osservare dettagli impercettibili di opere d’arte. Ma questa rappresentazione ultra-dettagliata non è "reale" nel senso diretto del termine: è una interpretazione convenzionale, una trasposizione dell’opera attraverso il sistema raster. Vediamo i puntini, non il quadro.

Un esempio emblematico è il dipinto “Gli Ambasciatori” di Hans Holbein: l’immagine nasconde un teschio distorto, visibile solo da un’angolazione specifica. È un’opera che interagisce con la percezione e sfida il sistema grafico convenzionale.

L’evoluzione del raster: dai layer all’Intelligenza Artificiale

In origine, i programmi di grafica raster non prevedevano layer (strati), un concetto più tipico del mondo vettoriale. I layer sono stati successivamente introdotti, rivoluzionando la grafica raster e consentendo un controllo molto più preciso sulle immagini.

Oggi, Photoshop e le fotocamere stesse integrano l’intelligenza artificiale, permettendo operazioni come il riconoscimento automatico di oggetti e volti, fino alla ricostruzione delle immagini.

16.10.2024

L7: Evoluzione del computer. Dal pallottoliere allo schermo grafico e oltre

vai alla lezioneLa scena tecnologica nel corso delle generazioni

Il progresso tecnologico ha definito e plasmato ogni generazione, accompagnando la società verso nuove modalità di comunicazione e invenzione. Ogni epoca ha visto l'introduzione di uno strumento tecnologico capace di trasformare radicalmente la vita delle persone:

- Ai tempi di Garibaldi il telegrafo: una rivoluzione nei tempi e nelle distanze della comunicazione, che ha reso possibili le comunicazioni istantanee tra città e continenti.

- Ai tempi di Terragni il cinema: una nuova forma di narrazione che ha cambiato il modo di interpretare la realtà e diffondere cultura.

- Ai tempi di Maiorana la radio: un mezzo di comunicazione di massa, che portava notizie, musica e cultura ovunque.

- Ai tempi di Steve Jobs il Macintosh: l’inizio della rivoluzione del personal computer, che rende la tecnologia accessibile e creativa.

- Ai giorni nostri l’iPhone: lo smartphone che ha portato il mondo in tasca, cambiando per sempre il nostro modo di connetterci e interagire.

0. Bibliografia del Ciclo II

Stan Augarten, Bit by Bit, Ticknor & Fields, New York 1984

Andrew Fluegelman, "The Making of the Macintosh", MacWorld, n.1, gennaio 1984

Ted Nace, "The Macintosh family tree", MacWorld, n.5, novembre 1984

Paul Freiberger, Michael Swaine, Fire in the valley. the making of personal computer, Osborne/McGraw-Hil, Berkeley, 1984

Gerhard Schmitt, Microcomputer Aided Design, Wiley interscience, New York 1988

Jeffrey S. Young, Steve Jobs. The Journey is the reward, Scott Foresmanand Co, Glenview 1988

Antonino Saggio, "I Nervi di Morandi o le reti di Musmeci", Arch.it, 20 Novembre 2000.

link all'articolo

1. Calcolo a leva umana

I calcoli, nella loro storia, hanno sempre coinvolto strumenti o metodi che sfruttavano risorse umane per eseguire operazioni complesse. Dall’abaco ai primi calcolatori meccanici, l’obiettivo era quello di facilitare e accelerare i processi di calcolo, riducendo il carico cognitivo umano. Questi sistemi si evolvono fino a diventare completamente autonomi con l’avvento dei computer elettronici, ma il principio della "leva umana" resta fondamentale in quanto ispirazione alla base di ogni strumento tecnologico.

2. La macchina dell’inventore: il contributo di Babbage e Boole

Charles Babbage,

con il suoi studi e progetti sulla Macchina Differenziale, fu il primo a immaginare una macchina capace di eseguire calcoli in maniera automatica. Le sue "tavole dei numeri" erano destinate a risolvere problemi matematici complessi, mentre il concetto di "ordine delle differenze" costituiva il nucleo del calcolo meccanico.

Accanto a lui, il matematico

George Boole

gettava le fondamenta della logica che avrebbe alimentato i futuri calcolatori.

Boole formalizzò concetti come AND, OR, NOT, elementi base della logica booleana, oggi essenziali nella programmazione. Il sistema di Boole riscopriva il linguaggio binario inventato da

Leibniz,

un codice di base che, a differenza del Codice Morse del 1835, funzionava su due soli segni: 0 e 1. Il codice Morse è più primitivo in quanto utilizza cinque segni, creando pause di lunghezza variabile per le comunicazioni. L'idea binaria di Boole, invece, è il cuore della logica dei computer, grazie alla semplicità e alla potenza di un linguaggio a due stati.

3. La crescita di IBM

IBM,

inizialmente nota per i suoi calcolatori elettromeccanici, è stata una delle prime aziende a comprendere il potenziale dei computer nel settore industriale.

Con l'introduzione dei mainframe negli anni '50 e '60, IBM ha dato forma a una nuova era, proponendo computer come strumenti di gestione aziendale. Questa crescita segnò anche l'inizio della standardizzazione dei sistemi, facendo di IBM un punto di riferimento e dando impulso alla nascita del concetto di personal computer.

4. Dal transistor al chip: L’innovazione italiana con l’ELEA

Il passaggio dal transistor al chip segnò una delle evoluzioni più importanti della tecnologia moderna.

Degno di nota è l’

ELEA,

prodotto dall’italiana

Olivetti,

che fu il primo computer interamente basato su transistor. Disegnato da

Ettore Sottsass e

Mario Tchou,

questo computer rappresentava un equilibrio tra innovazione tecnica e bellezza estetica, mostrando come il design italiano potesse abbracciare la tecnologia avanzata.

5. L’avvento del personal computer

L’idea del personal computer si sviluppò a partire dagli anni '70, quando gli strumenti elettronici diventarono più piccoli e accessibili. I primi personal computer, prodotti da aziende come

Apple e

Commodore,

rivoluzionarono l’idea stessa di “computer”, portandolo nelle case e nelle scuole.

Questa fase portò a una democratizzazione della tecnologia, aprendo le porte alla creazione di software e applicazioni personali.

6. DOS, PC e la legge di Moore

Il sistema operativo DOS, insieme alla legge di Moore (che prevede il raddoppio della potenza dei processori ogni due anni), ha reso possibile l’esplosione del PC come strumento universale. Con il DOS, IBM stabilì un modello operativo standard, permettendo a sviluppatori di tutto il mondo di creare software compatibili, aprendo la strada alla crescita del mercato del personal computer.

7. Mac e bit: le tappe del Macintosh e la storia del mouse

L’evoluzione del Macintosh segna una pietra miliare nella storia del design dell’interfaccia grafica e delle applicazioni multimediali. Dal QuickDraw del 1983 al PostScript del 1985, dal QuickTime VR del 1996 fino alla creazione di Sherlock nel 1998, il Mac ha definito uno standard di interazione intuitiva e di qualità visuale.

Un aspetto significativo di questa storia è la nascita del mouse, raccontata nell’articolo di Ted Nace su MacWorld (novembre 1984), in cui viene tracciata l’evoluzione di questo accessorio rivoluzionario che ha trasformato l’interazione tra uomo e macchina, rendendola più semplice e naturale.

8. Bit: Hardware, Schermo BitMap, e Plug-in

La rivoluzione del "bit" è definita dalla sinergia tra hardware, schermo bitmap e plug-in di sistema, creati per interagire simultaneamente. Tra le pietre miliari tecnologiche citiamo il QuickTime VR (1996), precursore di sistemi come

Google Earth;

la condivisione schermo (2008), il riconoscimento facciale (2009) e la georeferenzialità delle foto (2009), tutti strumenti che hanno contribuito ad arricchire l’esperienza utente.

Con il lancio di

Siri

il 12 ottobre 2012, l'intelligenza artificiale è entrata nel nostro quotidiano, aprendo nuove possibilità di interazione e ampliando il concetto stesso di bit come interfaccia tra significato e semantica.

↑ Torna su